- Onderzoek

- 21/03/2013

Met andere ogen

Wij vinden onze weg door de wereld hoofdzakelijk door op onze ogen te vertrouwen. Voor robots is het daarentegen veel minder vanzelfsprekend om zich te oriënteren op basis van visuele input. Promovendus ir. Roel Pieters ziet echter een grote toekomst voor ‘vision-based robot control’. Op maandag 25 maart promoveert hij bij Werktuigbouwkunde.

De meeste robots zijn blind. Dat is niet erg zolang ze maar in een omgeving werken waar geen onverwachte dingen gebeuren. Robots aan de lopende band, die niets anders doen dan schroefjes oppakken en indraaien, of metalen platen aan elkaar lassen, hoeven zich geen visueel beeld te vormen van de omgeving. Ze verrichten telkens weer exact dezelfde handeling en kunnen dus blind het volgende schroefje vinden.

Het wordt anders wanneer je robots in een huiselijke omgeving wilt inzetten, bijvoorbeeld als zorgrobot in verpleegtehuizen. Veiligheid staat in dat geval voorop. Een zorgrobot mag uiteraard in geen geval in botsing komen met een hulpbehoevende bejaarde. Hij moet daarom snel kunnen reageren als er plotseling iets op zijn pad komt.

Om ons te oriënteren in een ruimte, voorwerpen te zoeken en obstakels te vermijden, vertrouwen we vooral op ons gezichtsvermogen. Het ligt daarom voor de hand om ook robots van ‘ogen’ te voorzien. Er zijn tegenwoordig voldoende handzame videocamera’s beschikbaar. Toch staat visuele perceptie bij robots nog in de kinderschoenen.

De voornaamste reden hiervoor is de rekenkracht die je nodig hebt om visuele data -videobeelden- te verwerken, legt promovendus Roel Pieters uit. “Zo’n veertig procent van onze hersencapaciteit gaat op aan beeldverwerking. En ons brein is een soort parallelle processor, die miljoenen bewerkingen tegelijk kan uitvoeren. Dat is niet te vergelijken met een computer.” Tot voor kort werd visuele aansturing van robots daarom te veel beperkt door de tijd die het kostte om beelden om te zetten in een stuursignaal. Pas de laatste jaren zijn pc’s krachtig genoeg om robots ‘realtime’ aan te sturen op basis van video-input.

Wat dat betreft zijn we ver gekomen sinds de eerste ‘visueel gedreven’ robot van veertig jaar geleden; die had nog tien seconden nodig om een eenvoudige doos te herkennen - beslist onvoldoende om bewegende mensen of voorwerpen te ontwijken. Inmiddels is zelfs Pieters’ laptop in staat om als ‘brein’ te fungeren van een robotarm, die hij voorwerpen liet herkennen en oppakken.

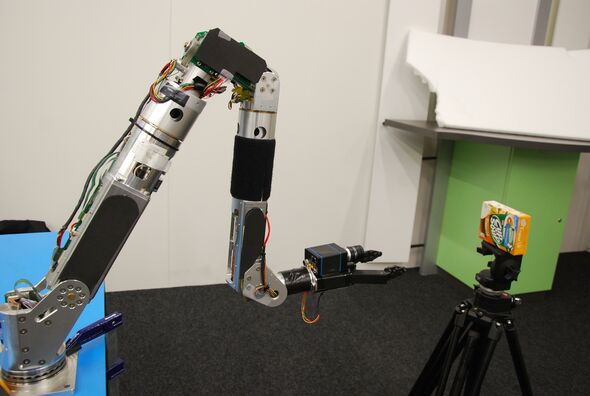

De bewuste arm, ongeveer een meter lang, is normaal gesproken onderdeel van ROSE, de Remotely Operated Service Robot die aan de TU/e wordt ontwikkeld. In tegenstelling tot die andere Eindhovense zorgrobot, AMIGO, is ROSE niet autonoom, vertelt Pieters. “ROSE wordt als het ware vanuit een cockpit bestuurd. Een operator, bijvoorbeeld een medewerker van een zorginstelling, ziet op een beeldscherm wat de robot op dat moment ziet en kan vervolgens uit een menu de gewenste actie van de robot selecteren.” Het is natuurlijk ondoenlijk om de bewegingen van ROSE vanuit de cockpit tot in detail bij te sturen. Via welke route en met welke snelheid de robot op zijn doel afgaat, zal het apparaat zelf moeten bepalen.

Voor zijn promotie ontwikkelde Pieters een op visuele input gebaseerde trajectplanning voor robots. Met een ‘traject’ wordt niet alleen de route bedoeld die de robot in een kamer aflegt, maar ook de beweging die de grijparm maakt om een voorwerp, zoals een pakje cup-a-soup, op te pakken. Bijzonder aan Pieters’ aanpak was dat hij de robot ook rekening liet houden met zijn eigen fysieke beperkingen, zoals zijn acceleratievermogen en topsnelheid. Dat maakt een betere afweging mogelijk als er plotseling bewegende voorwerpen, zoals een bejaarde achter een rollator, in het blikveld opduiken.

Voor een zorgrobot is het leren herkennen van voorwerpen essentieel. Pieters bedacht een algoritme waarmee de robot afbeeldingen uit zijn geheugen vergelijkt met de beelden die hij via zijn camera binnenkrijgt. “Het algoritme definieert automatisch een aantal interessante punten die in het geheugen worden opgeslagen”, legt hij uit. “Als die referentiepunten matchen met een object dat binnen zijn gezichtsveld komt, herkent de robot het betreffende voorwerp.” De afstand van het voorwerp schat de robot in aan de hand van het verschil in grootte tussen de live-plaatjes en de afbeeldingen in zijn geheugen.

In experimenten met de robotarm van ROSE, liet Pieters zijn laptop (het brein van de robot) tien maal per seconde de camerabeelden analyseren. Aan de hand van de beelden beslist de robot waar de arm naartoe moet bewegen, en met welke snelheid of acceleratie, om zijn doel te bereiken. Veel vaker dan tien keer per seconde is nog niet haalbaar, vertelt hij, mede doordat op dezelfde laptop ook de aansturing van de arm wordt berekend. “Op de arm is een camera geïnstalleerd die zwartwitbeelden opneemt van 640 bij 480 pixels. De processor van mijn laptop kan die met een frequentie van ongeveer tien Hertz verwerken.”

Het kan ook sneller. In een eerder project werkte Pieters aan een eenvoudiger systeem, bedoeld om OLEDs, plastic LEDs voor displays, te maken. “Daarvoor was een beeld van 160 bij 100 pixels voldoende. Dat maakte een veel hogere beeldverwerkingsfrequentie mogelijk, wel 1600 frames per seconde. Omdat de rekencapaciteit begrensd is, moet je altijd een afweging maken tussen de snelheid van de beeldverwerking en de nauwkeurigheid.”

Het OLED-project was voor Pieters een opstapje naar het programmeren van de robotarm, legt hij uit. “Bij de productie van OLEDs deponeert een robot een druppeltje polymeer op de positie van elk pixel. Dat kost maar een fractie van een milliseconde. Dat kan zo snel omdat de displays starre objecten zijn, die je heel snel onder de printkop door kunt laten bewegen.” Het grote voordeel van OLEDs is dat je ze ook op flexibele oppervlakken kunt maken. Die vervormen echter onder invloed van te snelle bewegingen of trillingen, waardoor je met ‘blinde’ robots onregelmatigheden krijgt in het patroon van pixels. Fabrikanten zijn daarom genoodzaakt om het productieproces aan te passen.

Pieters toonde aan dat je met behulp van een cameraatje en de juiste regelsoftware dit probleem (deels) kunt oplossen. “Het substraat (de ondergrond van de display, red.) moet daarvoor wel voorzien zijn van een regelmatig patroon, zodat de robot precies kan zien waar een printactie kan worden uitgevoerd.”

Een vergelijkbare strategie kan volgens de werktuigbouwkundige ook nuttig zijn bij het fabriceren van nog kleinere structuren, zoals computerchips. “In de industrie worden nu nog maar heel weinig robots aangestuurd op basis van videobeelden, maar ik verwacht zeker dat dit de komende jaren snel gaat veranderen.”

Discussie