Alternatieve hardware voor kunstmatige intelligentie

Supercomputers overtroeven de mens op steeds meer terreinen, maar verbruiken daarbij welhaast astronomische hoeveelheden energie. We ontkomen er daarom niet aan om over te stappen op radicaal andere hardware, geïnspireerd op ons eigen brein, analoog wellicht, met licht in plaats van elektronen, of zelfs op basis van DNA of quantumbits. Cursor sprak met een vijftal ambitieuze wetenschappers van de TU/e over hun visie en plannen.

Hoewel de term kunstmatige intelligentie (artificial intelligence, AI) al stamt uit de jaren vijftig van de vorige eeuw, heeft het lang geduurd voordat computersystemen met een bepaalde mate van lerend en probleemoplossend vermogen uitgroeiden tot méér dan leuke speeltjes in het lab. Inmiddels lijken we echter toch echt aan het begin te staan van het AI-tijdperk. De combinatie van de snel groeiende rekenkracht en nog veel sneller groeiende hoeveelheid data om AI-systemen mee te voeden, maakt kunstmatige intelligentie tot een dynamisch en invloedrijk onderzoeksgebied: AI ontwikkelt zich in rap tempo tot een technologie met de potentie om onze maatschappij radicaal te veranderen.

Toch dreigt er al meteen zand in de AI-motor te komen: sinds een aantal jaren worden computers niet langer exponentieel sneller, terwijl we nog wel elke twee jaar meer data genereren dan alles wat we daarvoor hebben geproduceerd. Het grootste obstakel op het pad naar nog slimmere AI wordt daardoor de energieconsumptie: doordat de rekenkracht per computerchip onvoldoende toeneemt, worden steeds grotere hoeveelheden processoren aan elkaar gekoppeld in zogeheten massief parallelle systemen. Deze bestaan meestal uit GPU’s, de Graphics Processing Units bekend van de videokaarten in spelcomputers. Op deze GPU’s kunnen zelflerende algoritmen draaien, maar wel tegen hoge energiekosten.

Om een idee te geven: AlphaGo, de computer die in 2016 Lee Sedol versloeg, wereldkampioen in het strategische bordspel go, verbruikte naar schatting een megawatt aan energie - vijftigduizend keer meer dan zijn menselijke tegenstrever. En dan hebben we het nog over een relatief beperkte supercomputer. De huidige topper Summit van IBM (150 petaFLOP/s) verbruikt 13 megawatt - genoeg voor dertienduizend huishoudens - en wordt daarmee energiezuinig genoemd. In vergelijking met de menselijke hersenen is AI dus bijzonder inefficiënt. En dat terwijl ons brein juist in toenemende mate een inspiratiebron is voor de manier waarop we computers willen laten functioneren, getuige de populariteit van zogeheten ‘neurale netwerken’ voor AI-toepassingen.

Het is daarom nodig alternatieven te vinden voor de huidige hardware op basis van siliciumtransistoren, waarop onze pc’s al decennialang naar tevredenheid hun ‘klassieke’ algoritmes draaien. Echte kunstmatige intelligentie stelt andere eisen aan de architectuur van hardware: misschien wel analoog in plaats van digitaal, met licht in plaats van elektronen, en van organisch kunststof in plaats van silicium. Voor medische toepassingen is rekenen met DNA wellicht logischer, en wat heeft de quantumcomputer ons te bieden? Aan al deze alternatieve vormen van computerhardware wordt ook aan de TU/e gewerkt.

1. Alternatieven in siliciumelektronica

Ook als je uitgaat van ‘standaard’ elektronische siliciumtechnologie, is er nog wel wat winst te behalen door de hardware specifiek te ontwerpen voor kunstmatige neurale netwerken. Henk Corporaal, hoogleraar in de groep Electronic Systems, houdt zich al zo’n vijfendertig jaar bezig met computerarchitectuur. “Waar vroeger vooral werd gekeken naar rekenkracht per oppervlakte, is nu ook het energieverbruik per bewerking een zeer belangrijke parameter”, vertelt hij.

Neurale netwerken

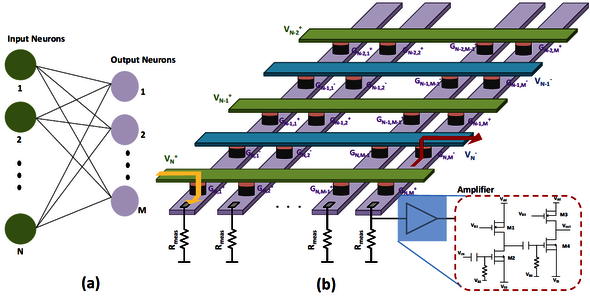

Bij ‘machine learning’ wordt een AI-systeem gevoed met gelabelde trainingsdata en leert zo categorieën onderscheiden. Op die manier kan de computer bijvoorbeeld zelf het verschil tussen afbeeldingen van honden en katten leren zien (of leren wat een goede zet is in een bordspel), zonder een expliciete omschrijving van de verschillen tussen die twee dieren. Kunstmatige neurale netwerken, die de architectuur van onze hersenen nabootsen, blijken bijzonder goed in dergelijke taken. Neurale netwerken bestaan uit enkele lagen ‘neuronen’, verbonden via links van variabele sterkte. Tijdens het trainingsproces wordt de sterkte (het 'gewicht') van die links aangepast voor een specifieke taak, zodat het netwerk in staat is om nieuwe input te classificeren. Dat laatste wordt ‘inference’ genoemd. Neurale netwerken kunnen worden geprogrammeerd op standaard computerchips, maar speciaal voor dit doel ontworpen hardware is in principe veel efficiënter.

Als we het hebben over energieverbruik, is vooral het (tijdelijk) wegschrijven van gegevens in het computergeheugen het probleem. Een bit opslaan in een lokaal geheugen kost tweehonderd maal zoveel energie als een elementaire optelling, laat Corporaal zien, en draadloos verzenden en vervolgens opslaan in de cloud zelfs tot vijftig miljoen maal zoveel.

Dat maakt meteen duidelijk waarom het trainen van neurale netwerken zoveel energie vreet: bij het vaststellen van de juiste parameters (de ‘gewichten’ die aangeven hoe sterk de kunstmatige neuronen met elkaar verbonden zijn) moeten waardes voortdurend worden teruggekoppeld en daarom tijdelijk onthouden. Ook is het dus vanuit oogpunt van milieu (en financiën) belangrijk om zoveel mogelijk lokaal te rekenen en op te slaan - precies het omgekeerde van de huidige trend in ‘cloud computing’ en online diensten. Onderzoekers werken daarom aan alternatieve architecturen, waarin geheugenelementen dichtbij de processoren worden geplaatst om ook het datatransport op de chip te minimaliseren.

Werken met minder bits is veel efficienter en blijkt voor neurale netwerken vrijwel altijd voldoende nauwkeurig

Daarnaast wordt parallel rekenen, zoals dat in GPU’s al gebeurt, momenteel steeds verder geperfectioneerd, vertelt Corporaal. “Bedrijven als NVIDIA werken aan zogeheten ‘tensor cores’ waarin matrixproducten in één klap worden uitgerekend. Om dat energiezuiniger te maken, werken die speciale processoren niet met 64 of 32 bits, zoals we in onze personal computers gewend zijn, maar met 16 of zelfs 8 bits. Dat blijkt voor vrijwel alle toepassingen met neurale netwerken voldoende nauwkeurig, en is veel efficiënter.”

Elk bit dat je niet hoeft te transporteren of weg te schrijven levert direct energiewinst op. De heilige graal is daarom volgens de hoogleraar om uiteindelijk naar systemen te gaan die werken met getallen van 1 bit. “Daar houden wij ons hier ook mee bezig. Je verliest dan natuurlijk wel nauwkeurigheid, het is geen free lunch, en dat moet je op de een of andere manier compenseren, bijvoorbeeld door met een groter aantal kunstmatige neuronen te werken.”

Optellen in plaats van vermenigvuldigen

Rekenen met getallen van 1 bit (‘0’ of ‘1’) brengt nog weer wat bijzonderheden met zich mee, legt Corporaal uit. “In plaats van vermenigvuldigen kun je XNOR-schakelingen gebruiken en de uitkomsten daarvan optellen. Dat is ook weer zuiniger dan vermenigvuldigen. Om een idee te geven: de Summit supercomputer verbruikt 65 picojoule per bewerking. Ga je naar 8 bits, dan kom je op ongeveer 1 picojoule. Met 1 bit is het record nu twintig femtojoule per bewerking; dat is vijftig keer zuiniger. En we hebben nu een voorstel lopen waarmee we naar 1 femtojoule willen komen. Maar dan nog werken onze hersenen veel efficiënter.”

Vaak is iets ongeveer weten wel goed genoeg; daar kun je gebruik van maken in 'approximate computing'

Onze hersenen zijn minder nauwkeurig dan conventionele computers, en dat is volgens Corporaal een reden waarom ze zo energiezuinig zijn. “Vaak is iets ongeveer weten wel goed genoeg, je mag er best een beetje naast zitten. Het is ook niet erg als er een paar hersencellen uitvallen, er is genoeg redundantie - ook in de geheugenfunctie. Je hebt zo’n honderd miljard neuronen, die elk tot wel tienduizend verbindingen hebben met andere neuronen; die connecties vormen ons geheugen. Het gaat daarom pas fout als een aanzienlijk deel van de hersencellen afsterft. Hoe we ook in computers gebruik kunnen maken van dergelijke principes, onderzoeken we hier ook in projecten rond ‘approximate computing’.”

In een poging om de hersenen na te bootsen, wordt bij Electronic Systems ook gewerkt aan zogeheten ‘memristors’- waarin de geheugenfunctie wordt vervuld door programmeerbare elektrische weerstandjes. “Die kun je meer of minder geleidend maken, in twee of meer standen.” Met memristors in een zogeheten ‘crossbar array’-configuratie kun je de geheugen- en rekenfunctie op één plek in de computer samenbrengen; net als in de hersenen, aldus Corporaal. “Dan heb je het dus over analoge componenten, die je kunt inbouwen in een digitaal systeem.”

2. Fotonische chips

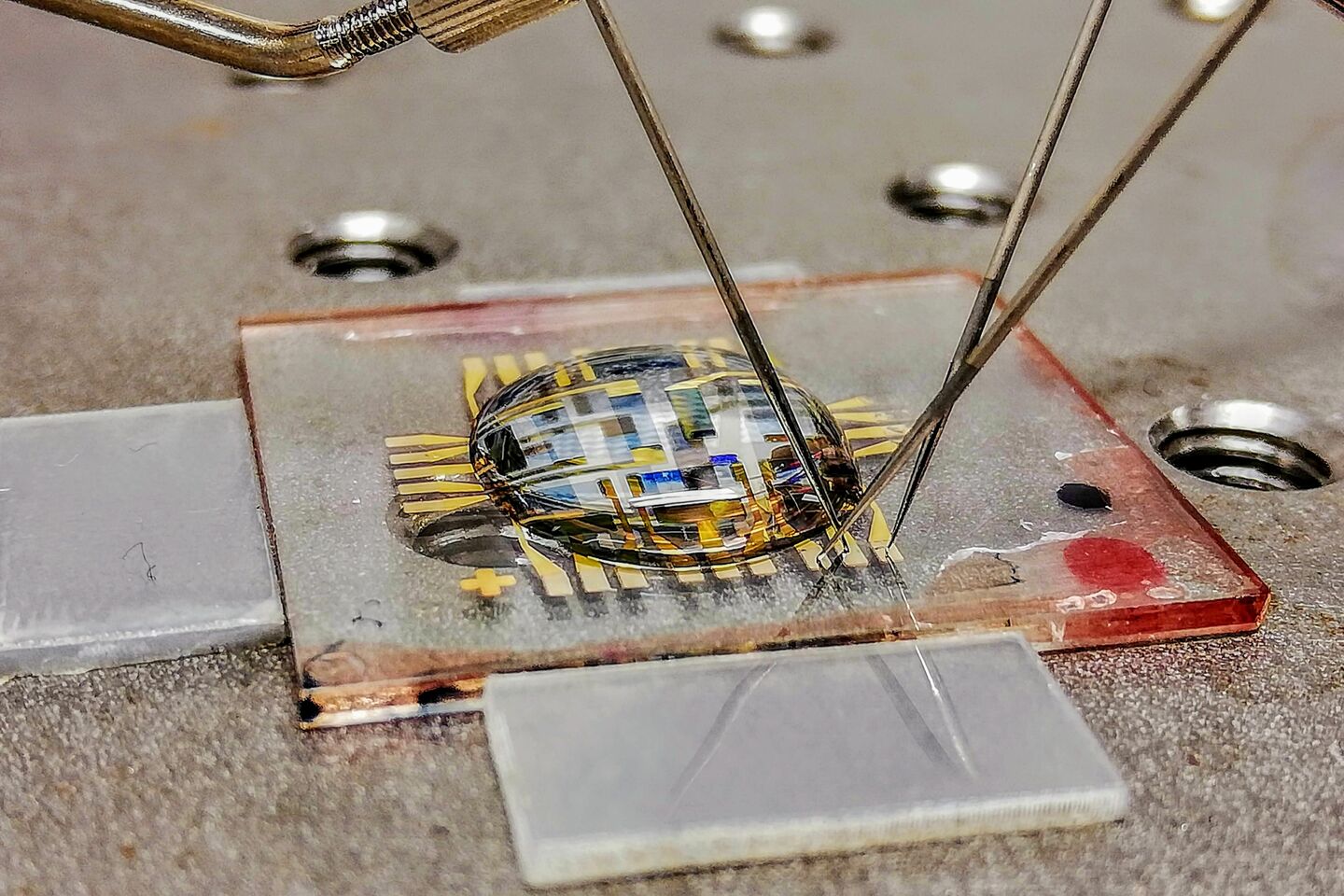

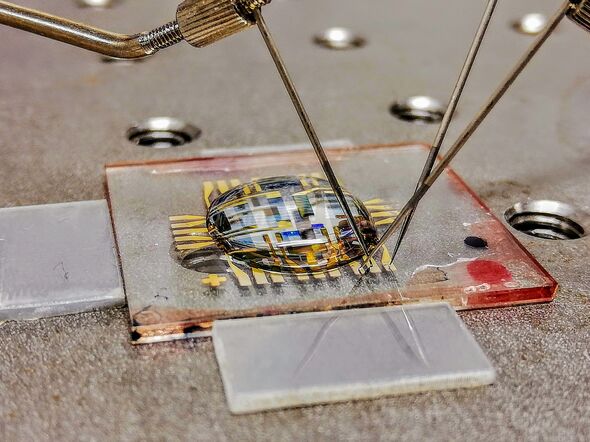

Patty Stabile is universitair docent in de groep Electro-Optical Communication Systems (EE) en expert op het gebied van fotonische chips, in het bijzonder voor toepassing in neurale netwerken. Dit zijn computerchips waarop een deel van de informatieverwerking niet met elektronen gebeurt, maar met licht.

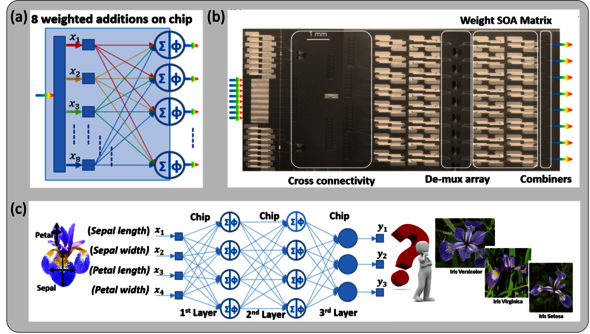

Over langere afstanden vindt transport van digitale data tegenwoordig vooral plaats in glasvezelkabels: met licht dus, in plaats van met elektronen. Dat is omdat je in de vorm van licht veel grotere hoeveelheden data kunt verzenden met relatief weinig energieverlies, legt de Italiaanse onderzoeker uit. “Ons doel is om ook op de chips zelf met licht te werken, dus voor datatransport, maar ook voor de berekeningen. Als je de juiste architectuur hebt, kun je op fotonische chips een vrijwel onbeperkt aantal bewerkingen gelijktijdig uitvoeren; je kunt er namelijk een groot aantal lichtbundels tegelijk doorheen sturen, zonder dat die elkaar in de weg zitten. Dat betekent ook dat het energieverbruik per bewerking snel daalt met een toenemende input data rate.”

We waren de eersten met acht fotonische neuronen in een enkele laag

De TU/e loopt wereldwijd al jaren voorop op het gebied van fotonische chips. Stabile vertelt dat zij en haar collega’s onlangs een optisch neuraal netwerk hebben gedemonstreerd - met drie lagen van elk acht kunstmatige neuronen - op basis van een chip van indiumfosfide (InP) die ze zelf al in 2011 aan de TU/e had gemaakt. “Acht neuronen klinkt misschien niet als een indrukwekkend aantal, maar hiermee waren we de eersten met zoveel fotonische neuronen in een enkele laag. En ook met betrekkelijk weinig fotonische neuronen kun je enorm hoge rekensnelheden bereiken, omdat signalen gelijktijdig verwerkt kunnen worden. We komen op acht miljard bewerkingen per seconde!”

Met haar collega’s liet Patty Stabile vorig jaar zien dat je met zo’n fotonisch neuraal netwerk al aan beeldclassificatie kunt doen door het netwerk los te laten op een klassiek voorbeeld van classificatie: het indelen van afbeeldingen van irissen (de bloemen) in drie categorieën. Daarbij bleek dat de meeste fouten ontstonden bij het omzetten van fotonische naar elektronische signalen en vice versa. “Ons doel is daarom om alle berekeningen zoveel mogelijk in het optische domein te doen om zo te komen tot een volledig optische classificatie. Het ‘trainen’ van het netwerk voor die taak, dat voorafgaand moet worden gedaan, kan helaas nog niet met een volledig fotonisch netwerk, omdat er nog geen betrouwbaar optisch geheugen bestaat. Voor dat trainen kun je echter al wel optische en elektronische methodes combineren.”

Hoewel de input voor dit experiment bestond uit 6-bits digitale data, bleek dat het fotonische neurale netwerk het best presteerde als deze bits werden omgezet naar een analoog lichtsignaal met 64 niveaus. “Analoog werkt sneller, mits de kwaliteit van de signalen voldoende zijn”, legt Stabile uit. “In de praktijk wil je misschien zelfs digitale en analoge optische signalen combineren in verschillende lagen van het netwerk om zo de complexiteit van ons brein na te bootsen.”

3. Plastic brein

Net als Henk Corporaal houdt ook Yoeri van de Burgt, universitair docent in de sectie Microsystems (Werktuigbouwkunde), zich bezig met memristors. Hij gebruikt daarvoor echter heel andere materialen dan de gebruikelijke siliciumtechnologie: Van de Burgt experimenteert met elektrisch geleidende polymeren, vergelijkbaar met de materialen waarvan plastic zonnecellen en OLED-beeldschermen worden gemaakt.

“In ons brein zijn de hersencellen of neuronen verbonden via zogeheten synapsen”, legt hij uit. “Een neuron kun je beschouwen als het rekencentrum, de processor, van onze hersenen, terwijl de synapsen de geheugenfunctie vervullen. Dat komt doordat de verbinding via de synapsen sterker wordt als deze vaker wordt gebruikt. Als bepaalde neuronen vaak met elkaar communiceren, door iets vaak te doen of te leren, ontstaat er een soort elektronische snelweg tussen die neuronen. Dat is hoe ons geheugen werkt.”

Geleidende polymeren zijn heel geschikt om een kunstmatige variant van neuronen te maken, legt Van de Burgt uit. “Ze werken bij zeer lage vermogens, en je kunt de elektrische weerstand makkelijk aanpassen door ionen toe te voegen of te verwijderen. Dat lukt al goed in een ‘natte’ omgeving en we zijn nu mede samen met het Holst Centrum bezig dit ook schaalbaar te maken in een meer praktische, ‘droge’ situatie.” Het grote voordeel van de ‘plastic’ synapsen is dat ze echt analoog zijn, benadrukt hij. “De memristors van anorganische materialen kun je hooguit in een paar stappen tunen, maar bij geleidende polymeren is dat een continue schaal.”

Kunstmatige synapsen kun je zien als lerende sensoren

Toepassing van zijn kunstmatige neuronen ziet Van de Burgt bijvoorbeeld in labs-on-a-chip, waar ze kunnen worden getraind om bepaalde moleculen of cellen te herkennen en classificeren in bloed, speeksel, of urine. “Omdat ze zo weinig energie verbruiken, komen ze juist in aanmerking voor dat soort stand-alone toepassingen. We willen ze zo leren om bijvoorbeeld tumorcellen in het bloed te herkennen. Of aan de hand van een zweetmonster vaststellen of iemand taaislijmziekte heeft.”

Ook maakten de werktuigbouwkundige en zijn collega’s al kunstmatige synapsen die reageren op dopamine, een belangrijke signaalstof in het natuurlijke brein. Dat maakt volgens hem de weg vrij voor toepassing in het lichaam. “Je hebt in feite een lerende sensor, die je kunt gebruiken voor ‘advanced prosthetics’, waarbij de patiënt een prothese - een onderarm bijvoorbeeld - leert aansturen.” Het leren vindt dus niet alleen plaats in het brein van de patiënt, maar ook in de - kunstmatig intelligente - prothese zelf. “Zo maak je optimaal gebruik van de adaptieve eigenschappen van onze materialen, en het feit dat ze biocompatibel zijn.”

4. Computer van DNA

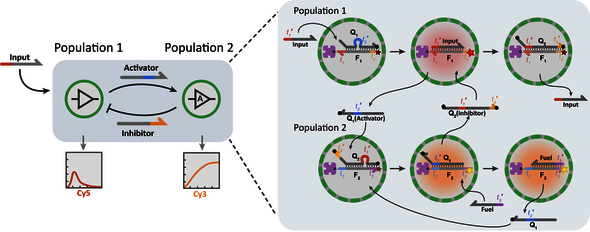

Als je één materiaal moet noemen dat verenigbaar is met levende systemen - biocompatibel, zoals Van de Burgt het uitdrukt-, is het wel DNA, het molecuul waarin de code voor het leven zelf is vervat. Maar dat je DNA ook kunt inzetten voor kunstmatige intelligentie, zal voor velen een verrassing zijn. Toch is dat wat Tom de Greef, universitair hoofddocent Synthetische Biologie, voor ogen heeft. “Er bestaan al neurale netwerken op basis van DNA die moleculaire patronen kunnen classificeren. Aan Caltech hebben ze zelfs al een lerend neuraal netwerk van DNA weten te maken.”

DNA-reacties programmeren

DNA-moleculen bestaan simpel gezegd uit ketens van vier verschillende moleculen, zogeheten basen, die worden aangeduid met C, G, A en T: de letters waarmee onze genetische informatie is vastgelegd. Doordat zowel de C en de G als de A en de T onderling paren vormen, kunnen twee strengen met de juiste - complementaire - volgorde van basen als het ware aan elkaar ritsen. Op die manier bepaalt de basevolgorde van strengen met welke andere DNA-moleculen ze kunnen reageren. Daardoor kun je van tevoren de gewenste reacties programmeren, vergelijkbaar met het schrijven van software.

Het ligt voor de hand dat DNA-computing vooral nuttig kan zijn in het biomedische domein, benadrukt De Greef. “Veel aandoeningen kun je in het bloed opsporen aan de hand van microRNA.” DNA kan aan deze korte stukjes erfelijk materiaal binden, waardoor een soort kettingreactie in gang wordt gezet die leidt tot een uitkomst: ziek of niet ziek. “Vaak moet je naar meerdere varianten van microRNA kijken voor een diagnose, en dat zijn nu nog allemaal verschillende handelingen. Je moet waarden uitlezen, in een computer invoeren en daar een algoritme op los laten. Met een DNA-computer kan dat in een moeite door, in het bloed zelf; zo kun je dus veel werk besparen. Het is al gelukt om bepaalde ziektes vast te stellen met een DNA-computer. Dat werkt nog niet nauwkeurig genoeg, maar er is dus best al wel wat mogelijk.”

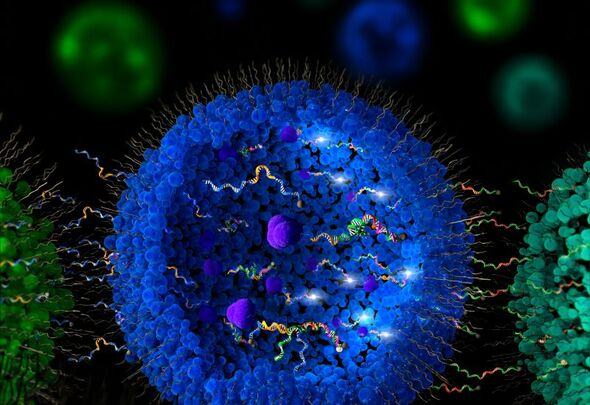

Data-opslag in DNA is nu al bijna goedkoper dan magnetische opslag

DNA kan daarnaast ook gebruikt worden voor opslag van grote hoeveelheden data. “Dat is heel nieuw, maar nu al bijna goedkoper dan magnetische opslag in datacentra. Je vertaalt de binaire data gewoon naar DNA-code, laat dat DNA synthetiseren en vervolgens vriesdrogen. In een paar gram DNA past net zoveel informatie als in een heel datacentrum. En je kunt de data weer uitlezen door het DNA te ‘sequencen’.” Met name voor archieven, waarin informatie ligt opgeslagen die niet vaak ingezien hoeft te worden, is dat volgens De Greef een zeer veelbelovende oplossing. “Het kost in verhouding met magnetische opslag nauwelijks energie.”

Chronische ziektes

De heilige graal van DNA-computing is om het rekenen met DNA te combineren met dataopslag in de vorm van DNA. De Greef heeft daar wel ideeën over. “Ik denk dat je CRISPR-Cas daarvoor kunt gebruiken. Je zou dan als het ware een moleculaire geschiedenis van de bewerkingen van de DNA-computer kunnen opslaan en uitlezen. Dat kan bijvoorbeeld handig zijn voor het monitoren van chronische ziektes.” Vorig jaar vonden hij en zijn collega’s omhulsels om de DNA-computers te beschermen tegen enzymen die anders roet in het eten zouden gooien. “Met die omhulsels in combinatie met een mechanisme om informatie weg te schrijven kun je heel mooie dingen doen”, zegt hij enthousiast.

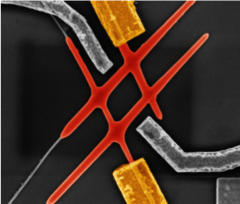

5. Quantumcomputer

In een verhaal over revolutionaire computers mag de quantumcomputer uiteraard niet ontbreken. De Eindhovense expert op dit gebied is Erik Bakkers, hoogleraar bij Advanced Nanomaterials & Devices. Zijn nanodraden kunnen mogelijk de bouwstenen vormen voor een quantumcomputer gebaseerd op Majorana-deeltjes, zo liet hij met collega’s uit Delft zien. Volgens hem spelen quantumcomputers beslist een rol in de plannen van techgiganten als Google, Microsoft en IBM voor kunstmatige intelligentie. Het zal dan echter om heel specifieke toepassingen gaan, denkt hij.

“Quantumcomputers zijn zeker niet beter in het verwerken van grote hoeveelheden informatie; het is niet eenvoudig om die data in te lezen. En vooralsnog werken ze alleen bij extreem lage temperaturen, je hebt dus een grote installatie nodig met een cryostaat, een soort vriezer. Mobiele toepassingen liggen dus ook niet voor de hand. Simpel gezegd kun je stellen dat quantumcomputers vooral goed zijn in quantummechanische problemen: het doorrekenen van grote moleculen bijvoorbeeld, en misschien zelfs virussen, om medicijnen te kunnen ontwikkelen.”

Vergeleken bij een datacentrum is een quantumcomputer erg energiezuinig

Daarnaast zouden quantumcomputers goed zijn in het kraken van beveiligingssleutels en het doorzoeken van een bepaald type databases. De daarvoor ontworpen algoritmes maken gebruik van het parallelle karakter van quantumcomputers: het feit dat elk bit niet een ‘0’ of een ‘1’ is, maar een soort optelsom van beide. Hierdoor kunnen berekeningen tegelijkertijd op alle invoer worden uitgevoerd, wat bij quantumcomputers met een groot aantal ‘qubits’ tot een enorme besparing leidt in tijd én energie. “Als je het vergelijkt met datacentra die honderden megawatts verbruiken, dan is een quantumcomputer met een cryostaat van tien kilowatt natuurlijk extreem zuinig.”

Al met al is Bakkers behoorlijk sceptisch over de mogelijkheden van quantumcomputers op de korte termijn. “Google is met haar project het verst, die hebben zo’n vijftig qubits. Maar die qubits zijn nog niet stabiel en hebben elk een miljoen andere hulpqubits nodig om te kunnen functioneren. Ze zijn er dus zeker nog niet, en ook een computer op basis van Majorana’s hebben we voorlopig nog niet gebouwd. Door de huidige hype rond quantumcomputers gaat de vooruitgang overigens wel sneller, simpelweg omdat er steeds meer mensen aan dit probleem werken.”

EAISI

De TU/e zet groots in op kunstmatige intelligentie: afgelopen zomer werd aangekondigd dat binnen het nieuwe Eindhoven Artificial Intelligence Systems Institute (EAISI) vijftig nieuwe wetenschappers zullen worden aangenomen, bovenop de honderd onderzoekers die al op dit terrein werken. De universiteit is van plan in totaal zo’n honderd miljoen euro te investeren, inclusief geldstromen vanuit de overheid (sectorgelden) en de verbouwing van Laplace, dat het onderkomen zal vormen voor het nu tijdelijk in het Gaslab ondergebrachte EAISI.

Discussie