De robot en de mens

Wie is aansprakelijk bij ongelukken met zelfrijdende auto’s? Hoe dient een robot zich te gedragen naar kinderen en hulpbehoevende mensen? In hoeverre mogen we politieke beslissingen overlaten aan slimme algoritmes? De ontwikkeling van artificiële intelligentie (AI) komt in een stroomversnelling, en zal steeds meer mensen raken in hun dagelijks leven. Binnen het Eindhovense AI-instituut EAISI is daarom niet alleen aandacht voor technische vraagstukken. Cursor sprak met kwartiermaker van EAISI Wijnand IJsselsteijn, techniekfilosoof Vincent Müller en jonge onderzoekers van het Social Robotics Lab over de menselijke en morele implicaties van kunstmatige intelligentie.

Wijnand IJsselsteijn is als hoogleraar Cognition and Affect in Human-Technology Interaction representant van de ‘mensgerichte’ zuil binnen het nieuwe AI-instituut van de TU/e. Die wordt met name vertegenwoordigd door zijn eigen groep Human-Technology Interaction en de groepen Human Performance Management en Philosophy & Ethics (alle van de faculteit Industrial Engineering & Innovation Sciences). Daarnaast valt veel van het onderzoek aan de faculteit Industrial Design onder die noemer, alsook een aantal projecten van de faculteit Bouwkunde.

Data krijgt tanden met AI, dus dat we nadenken over de implicaties lijkt me essentieel

Dat IJsselsteijn en universiteitshoogleraar Anthonie Meijers (tot voor kort leider van Philosophy & Ethics) deelnemen in het nieuwe Zwaartekrachtsprogramma Ethiek van Sociaal Disruptieve Technologie, is volgens hem een mooie samenloop van omstandigheden. “Dat biedt ons de mogelijkheid om binnen EAISI de ‘human-centered’ kant van AI wat meer body te geven”, zegt hij. “Kunstmatige intelligentie moet je niet alleen als een technisch probleem benaderen; ook de sociaalwetenschappelijke en filosofische kanten zijn heel belangrijk. Dat merk je ook aan hoe de maatschappij reageert op nieuwe ontwikkelingen in de AI. Het leeft heel erg.”

De TU/e zet groots in op kunstmatige intelligentie: afgelopen zomer werd aangekondigd dat binnen het nieuwe Eindhoven Artificial Intelligence Systems Institute (EAISI) vijftig nieuwe wetenschappers zullen worden aangenomen, bovenop de honderd onderzoekers die al op dit terrein werken. De universiteit is van plan in totaal zo’n honderd miljoen euro te investeren, inclusief geldstromen vanuit de overheid (sectorgelden) en de verbouwing van Laplace, dat het onderkomen zal vormen voor het nu tijdelijk in het Gaslab ondergebrachte EAISI.

Wijnand IJsselsteijn is één van de kwartiermakers van EAISI. De anderen zijn universitair hoofddocent Cassio Polpo de Campos (Information Systems, Wiskunde & Informatica) en hoogleraren Panos Markopoulos (Design for Behavior Change, Industrial Design), Paul van den Hof (Control Systems, Electrical Engineering, en één van de initiatiefnemers van het High Tech Systems Center van de TU/e) en Nathan van de Wouw (Dynamics & Control, Werktuigbouwkunde).

In zijn algemeenheid ziet IJsselsteijn dat mensen erg huiverig zijn voor kunstmatige intelligentie. “Gelukkig zijn we aardig op tijd met de discussie over de ethische implicaties van AI - het is nog geen voldongen feit. Die boot hebben we wel een beetje gemist bij big data. Daar zie je nu dat bedrijven als Facebook door de politiek worden teruggefloten. Maar data krijgt tanden met AI, dus dat we nadenken over de implicaties lijkt me essentieel.”

Aan de andere kant vindt de hoogleraar dat er over AI tegenwoordig wel heel makkelijk moord en brand wordt geschreeuwd. “Ik zie machines nog niet de macht overnemen, zoals sommigen voorspellen. Iemand als futuroloog Ray Kurzweil rekent uit wanneer de rekenkracht van computers die van de mens zal overtreffen, en beweert dan dat computers intelligenter worden dan mensen - dat is veel te kort door de bocht. Intelligentie is zoveel méér dan rekenkracht. AI is véél beperkter. Dat volledig autonome kunstmatige intelligentie zelf een honger naar macht zou ontwikkelen, vind ik persoonlijk ook een bijzondere aanname. Waarom zou dat zo zijn? Slim zijn is niet hetzelfde als iets willen. Bovendien kunnen we AI uitrusten met een waardesysteem dat die mogelijkheid uitsluit. We zijn zelf in charge. Ik zie AI meer als een potentiële aanvulling op onze eigen intelligentie op heel specifieke vlakken; een krachtige vorm van cognitief gereedschap.”

We lijken nu eenmaal minder vergevingsgezind voor fouten van machines dan van mensen

Daarnaast ziet IJsselsteijn ook morele consequenties van het níet inzetten van kunstmatige intelligentie. Hij vindt dat het morele debat zich niet alleen zou moeten richten op het gevaar van technologie als AI, maar ook op de voordelen. “Denk aan de zelfrijdende auto. Je kunt zeggen dat daar risico’s aan zijn verbonden, omdat ze nog niet volmaakt functioneren. Ze zullen waarschijnlijk ook nooit perfect worden. Maar daar moet je tegenover zetten dat er nu jaarlijks een miljoen mensen omkomen in het verkeer - veelal als gevolg van menselijke fouten. Als je dat aantal kunt terugdringen met zelfrijdende auto’s, dan zie ik het als een morele plicht om dat te doen. Zelfs al zal de focus komen te liggen op de gevallen dat de zelfrijdende auto een fout maakt. We lijken nu eenmaal minder vergevingsgezind voor fouten van machines dan van mensen.”

Dat laatste fenomeen is één van de dingen die IJsselsteijn graag binnen EAISI verder wil onderzoeken. “Aan de ene kant verwachten mensen misschien te veel van ‘AI agents’ en zijn daardoor weinig tolerant voor fouten, maar aan de andere kant kun je ook te weinig vertrouwen hebben in AI, waardoor je het systeem niet optimaal gebruikt. Als je niet gelooft dat je auto beter automatisch een noodstop kan maken dan jijzelf, en je daarom het systeem uitzet, dan schiet het natuurlijk niet op. Dat, en bijvoorbeeld de interactie van zelfrijdende auto’s met voetgangers, zou ik graag onderzoeken met de collega’s van het Automotive Lab.”

Wat de hoogleraar ook intrigeert, is hoe AI zich moet bewegen in een wereld waar niet iedereen het even nauw neemt met de regels. “Neem bijvoorbeeld het verkeer in een stad als Amsterdam. Voetgangers en fietsers nemen daar voorrang, ook als ze het niet hebben. Daar moet een zelfrijdende auto uiteindelijk mee kunnen omgaan. Dat betekent dat die in zekere zin flexibel moet zijn, de intenties van de overige weggebruikers moet kunnen inschatten en over de eigen intenties moet kunnen communiceren met de medeweggebruikers. Dat is in feite een sociaal onderhandelingsproces.”

Het is ethisch niet zo problematisch om een hondje rond te commanderen - in tegenstelling tot een vrouw

Iets anders waarmee IJsselsteijn binnen EAISI aan de slag zou willen, zijn de snel populairder wordende intelligente ‘interfaces’ zoals Google Home/Assistant en Amazon Echo/Alexa. “Alexa is standaard een vrouwenstem. Je kunt je afvragen of vanuit feministisch oogpunt zo’n ‘hulp in het huishouden’ wel een vrouw zou moeten zijn. En hoe manage je de verwachtingen van zo’n spraakassistent? Ik heb met Philips ooit een project gedaan met een intelligent agent in de vorm van een hondje. Dat is een slimme interactie-metafoor, want mensen snappen meteen dat een hondje niet alles letterlijk begrijpt, maar alleen bepaalde commando’s. En het is ethisch ook niet zo problematisch om een hondje rond te commanderen - in tegenstelling tot een vrouw.”

Daarnaast is IJsselsteijn geïnteresseerd in de mogelijkheden die AI biedt in de medische hoek. “Dan heb je het over personalised medicine en hoe je mensen kunt helpen om gezonder gedrag te vertonen. Daar zitten niet alleen technische aspecten aan, maar zeker ook psychologische en ethische. Mag je mensen proberen te beïnvloeden met intelligente systemen? En wat betekent dat voor de keuzevrijheid? Industrial Design is daarin beslist een partner als je het hebt over de quantified self en menselijke gezondheid en vitaliteit, maar ook Bouwkunde als je meer kijkt naar omgevingsfactoren, en hoe de gebouwde omgeving onze gedragskeuzes beïnvloedt.”

Social Robotics Lab

Bij kunstmatige intelligentie zullen veel mensen direct aan robots denken. Binnen het Social Robotics Lab, een gezamenlijk initiatief van de groepen Human-Technology Interaction (IE&IS) en Future Everyday (Industrial Design), wordt onderzocht hoe je robots geschikt kunt maken om te functioneren in een menselijke omgeving. Daarvoor zullen de robots bijvoorbeeld een bepaalde sociale intelligentie moeten ontwikkelen - ‘gevoel’ voor wat mensen wel of niet gepast vinden. Vooruitlopend op volledig autonome sociale robots wordt daarnaast onder meer gekeken hoe je kunstmatige en menselijke intelligentie op een slimme manier kunt combineren. Cursor sprak met promovendi Margot Neggers (HTI), Maggie Song en Tahir Abbas (beiden Industrial Design) over hun projecten.

Robots in je ‘personal space’

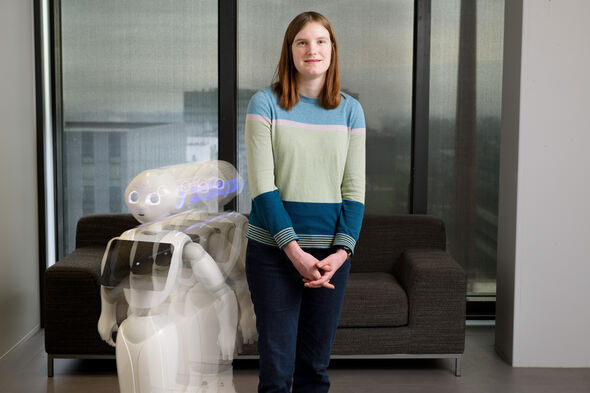

Margot Neggers is promovenda bij Human-Technology Interaction en werkt in het Social Robotics-lab met twee kleine NAO’s van zestig centimeter (Bender en Marvin gedoopt) en een twee keer zo grote Pepper (Eve genaamd, naar de robot uit de animatiefilm WALL-E).

Haar bescheiden lab in Atlas bestaat uit een halletje waar proefpersonen zich kunnen inschrijven op de computer, een kleine control room van waaruit de onderzoekers de experimenten kunnen observeren, en de eigenlijke labruimte met een bureau met computer, en een sofa die met zijn rug naar het raam - met prachtig uitzicht over Eindhoven - geparkeerd staat.

Bender en Marvin liggen op de sofa lui te wezen, Eve staat nog doodstil en met gebogen hoofd in het midden van de bescheiden ruimte, maar dat verandert als Neggers haar met een druk op de knop ‘wakker’ maakt. Meteen wordt de meerwaarde van een ‘humanoide’ robot als ‘drager’ van kunstmatige intelligentie duidelijk: met haar grote, beweeglijke ogen, die contact zoeken zodra je iets zegt, en de lichaamsgebaren die ze daarbij maakt, voelt Eve aan als een persoon. Iets tussen en mens en een huisdier in, als het ware. Het is dan ook goed voor te stellen dat robots als Eve het leven van bijvoorbeeld eenzame, hulpbehoevende ouderen niet alleen in praktische, maar ook in sociale zin kunnen veraangenamen.

Je moet je altijd afvragen wat de toegevoegde waarde is van het ‘lichaam’ van de robot

Van binnen is zo’n robot heel vergelijkbaar met de al algemenere spraakassistenten van Google, Amazon, Microsoft, Apple en Samsung die zijn ingebouwd in smartphones, ‘slimme speakers’ en zelfs koelkasten, geeft de promovenda toe. “Je moet je daarom altijd afvragen wat de toegevoegde waarde is van het ‘lichaam’ van de robot.” Robots als Eve worden met name in Japan al gebruikt in het openbare leven, vertelt Neggers. “Op stations geven ze informatie over vertrektijden en in winkels helpen ze mensen om de bepaalde producten te vinden.” In zo’n winkel is het feit dat ze kunnen rijden natuurlijk handig en op een station vallen ze meteen op. Bovendien is het fijn communiceren met een partner die je aankijkt om te laten zien dat ze aandacht voor je heeft.

Neggers onderzoekt hoe robots zich zouden moeten gedragen als ze zich samen met mensen in een ruimte bevinden. Daarvoor liet ze door proefpersonen aangeven wanneer Eve wat hen betreft onaangenaam dichtbij kwam. “Het blijkt dat de afstand die ze diende aan te houden, eigenlijk hetzelfde was als de personal space die je normaal ten opzichte van andere mensen in acht neemt. Het minst prettig vinden mensen het als de robot achter ze langs beweegt.”

De volgende stap is om de robots rekening te laten houden met bewegende mensen, vertelt ze. “We gaan specifiek kijken naar situaties waarin de paden van mensen en robots elkaar kruisen. Moet de robot dan versnellen, vertragen, helemaal stoppen, of om de mens heen gaan? We willen graag weten wat mensen als het prettigst ervaren.”

Als mensen robots niet vertrouwen, zullen ze nooit worden gebruikt

Uiteindelijk is het namelijk van groot belang dat mensen robots gaan vertrouwen. “Anders kun je nog zulke mooie robots ontwikkelen, maar zullen ze nooit worden gebruikt.” Het is de promovenda al wel opgevallen dat de omstandigheden cruciaal zijn voor dat vertrouwen: “Bij experimenten bewoog de robot soms vlak langs de proefpersonen. Zelf vond ik dat best een beetje eng, maar de proefpersonen schrokken er niet van. Zij gaven aan dat ze vertrouwen hadden in de universiteit en in mij als expert. Maar als je buiten opeens een onbekende robot tegenkomt, dan weet je niet of die bij een betrouwbare instantie hoort. Dat is ook nog een interessante kwestie om te onderzoeken.”

Aangemoedigd door een robot

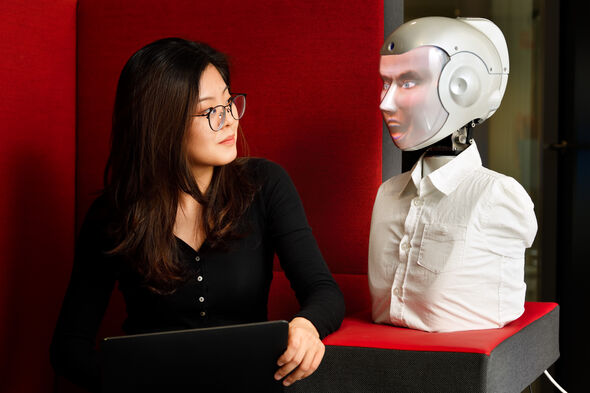

Ook Maggie Song promoveert binnen het Social Robotics Lab, maar dan bij de faculteit Industrial Design. Zij onderzoekt daar aan welke voorwaarden sociale robots moeten voldoen als je ze wilt gebruiken met kinderen. In een van haar projecten onderzocht ze hoe deze robots ingezet kunnen worden om kinderen te motiveren om hun best te doen voor muziekles. Daarbij maakt ze gebruik van de ‘SociBot’, een robot van het bedrijf Engineered Arts met een zeer levendige gezichtsuitdrukking. Die uitdrukking wordt van binnenuit op het gezicht geprojecteerd, en biedt daardoor eindeloze mogelijkheden om verschillende karakters uit te beelden.

“Kinderen vinden muziekles in het begin vaak leuk en spannend, maar uiteindelijk moet je toch ook gewoon veel uren maken”, legt de promovenda uit. Een robot die bij de oefensessies aanwezig is en feedback geeft, kan de kinderen daarbij motiveren, zo is de gedachte. “Ouders willen er liever niet bovenop zitten, omdat ze de tijd niet hebben, of omdat dit slecht is voor de relatie met hun kinderen.”

Tijdens experimenten met Eindhovense kinderen van negen tot twaalf jaar testte Song twee verschillende rollen voor de SociBot - oordelend (met specifieke tips) en niet-oordelend (als ondersteunend publiek). “We wilden weten of kinderen die rollen op dezelfde manier interpreteren - en dat blijkt het geval te zijn.”

Overigens is het aandeel kunstmatige intelligentie in dit stadium nog zeer beperkt, geeft ze toe. “We gebruikten de zogeheten ‘Wizard of Oz’-methode, waarbij wij vanuit een aparte ruimte de robot voorgeprogrammeerde reacties lieten geven.” Of de toejuichingen van de robot ook een positief effect hebben op de muzikale prestaties van de kinderen, kan Song nog niet zeggen. “Samen met een muziekdocent zijn we nog bezig de resultaten te analyseren.”

De robot als toegangspoort tot crowd workers

Tahir Abbas uit Pakistan is derdejaars promovendus bij Industrial Design. Binnen het Social Robotics Lab onderzoekt hij de (on)mogelijkheden van crowdsourcing voor AI-toepassingen. Het principe van crowdsourcing van flexibele online arbeidskrachten, die 24/7 inzetbaar zijn doordat de pool van arbeiders over meerdere tijdzones is verspreid, is sterk in opkomst. Bijvoorbeeld via Amazon Mechanical Turk kun je zogeheten Human Intelligence Tasks indienen, die vervolgens direct worden uitgezet onder de beschikbare crowdworkers.

In Abbas’ experimenten communiceert de gebruiker met een sociale robot, terwijl crowd workers eigenlijk de antwoorden geven. De robot fungeert dus in eerste instantie slechts als interface, als de link tussen de ‘klant’ en een pool van anonieme arbeidskrachten. De Pakistaan vertelt over een proef met een actrice, die een studente speelde die gebukt ging onder stress en eenzaamheid, en daarover met een life coach wilde praten.

“De ingehuurde crowd workers konden haar via de camera van de robot zien en horen, en dus direct reageren op haar vragen. Die reacties typten ze in en tekst werd vervolgens door de robot voorgelezen aan de actrice.” Om dat proces te versnellen, kun je de vraag ook doorzetten naar meerdere arbeidskrachten. Abbas en zijn collega’s testten dit met een, twee, vier en acht crowd workers en concludeerden dat de antwoorden significant sneller kwamen bij meer arbeidskrachten, terwijl de kwaliteit ongewijzigd bleef.

Dit systeem, ook wel aangeduid met ‘human-in-the-loop’, kan op termijn worden voorzien van daadwerkelijke kunstmatige intelligentie, legt Abbas uit. “We zijn nu bezig de robot, een Pepper, kort te laten reageren, puur om tijd te rekken voor de ingeschakelde arbeidskrachten. De volgende stap zou zijn om een zelflerend algoritme in te bouwen dat op steeds meer vragen ook zelf een goed antwoord kan geven.”

De ethiek van kunstmatige intelligentie

Vincent Müller is een expert op het gebied van de theorie en ethiek van kunstmatige intelligentie. De hoogleraar Filosofie van de Techniek werkt sinds afgelopen mei in de groep Philosophy & Ethics als opvolger van universiteitshoogleraar Anthonie Meijers. De Duitser heeft daarnaast aanstellingen aan de universiteit van Leeds en het Alan Turing Institute in Londen, en is onder meer voorzitter van de European Society for Cognitive Systems.

Het tijdperk van de kunstmatige intelligentie is pas net begonnen, benadrukt Müller. “Artificiële intelligentie zal onze samenleving meer veranderen dan de opkomst van computers in de afgelopen dertig jaar. Als je het vergelijkt met de industriële revolutie, dan zitten we nu nog maar in de fase van de eerste stoommachines. Terwijl over de eerste auto’s werd gesproken als horseless cariages, hebben we het nu over driverless cars." Zoals de associatie van auto’s met paardenkarren inmiddels uit ons bewustzijn is verdwenen, bedoelt hij maar te zeggen, zullen komende generaties zich niet meer realiseren dat auto’s ooit een bestuurder nodig hebben gehad.

Het is echter zeer de vraag of ons huidige raamwerk van normen een waarden een goede basis zal vormen voor onze omgang met dergelijke ingrijpende kunstmatige intelligentie. “Ethiek draait enerzijds om het afwegen van voor- en nadelen, om kosten en baten, en anderzijds om bepaalde absolute waarden. Zo vinden we het niet ethisch om een onschuldig persoon om te brengen zodat een groep andere personen daarvan kan profiteren, terwijl je dat op basis van een rationele analyse van kosten en baten wellicht die keuze wel zou maken.”

Misschien wel het grootste gevaar van kunstmatige intelligentie is dat we verantwoordelijkheid afwentelen op anonieme, ondoorzichtige systemen

Onze gedachten over die waarden zijn historisch gegroeid, maar zijn misschien niet toepasbaar op kunstmatige intelligentie, legt de filosoof uit. We willen graag dat iemand zijn keuze kan verantwoorden, maar wat als die ‘iemand’ een slimme machine is? Onlangs weigerde zijn Nederlandse bank hem een creditcard te verschaffen toen hij daartoe online een verzoek indiende, vertelt hij. Een typisch geval van computer says no.

“Ik kreeg geen uitleg waarom mijn aanvraag was afgewezen, terwijl ik dat beslist had geëist als ik tegenover een bankmedewerker had gezeten. Volgens de nieuwe Europese privacywetgeving heb ik ook recht op zo’n uitleg.” Die Algemene Verordening Gegevensbescherming (AVG) moet namelijk voorkomen dat organisaties wegkomen met het excuus dat ‘het systeem’ nu eenmaal zo heeft beslist, legt hij uit. “Dat is misschien wel het grootste gevaar van kunstmatige intelligentie: dat we verantwoordelijkheid afwentelen op anonieme, ondoorzichtige systemen.”

De vereiste dat AI explainable moet zijn, is volgens Müller dan ook cruciaal. “Kunstmatige intelligentie zal op dezelfde manier discrimineren als wijzelf als we het systeem voeden met data uit het verleden. De AI zal denken dat dit zo hoort. We moeten erg oppassen dat met name onze onbewuste discriminatie niet wordt overgenomen door intelligente systemen.”

Als machines slimmer zijn dan wij, verliezen we in zeker opzicht de controle

In Müllers betoog zijn de consequenties van kunstmatige intelligentie nauw verweven met het verzamelen van persoonlijke data en in hoeverre we daar op een verantwoorde, privacy-respecterende manier mee omgaan. “Artificiële intelligentie zal in steeds sterkere mate onlosmakelijk verbonden raken met het vergaren en verwerken van data. Neem dit gesprek, dat je nu opneemt. We kunnen nu nog niet inschatten wat daar op termijn voor informatie uitgehaald kan worden met behulp van AI. Misschien valt aan de manier waarop ik praat af te leiden dat ik over twintig jaar bijvoorbeeld Alzheimer zal ontwikkelen. Dat is niet uit de lucht gegrepen: het blijkt dat je in de manier waarop iemand loopt een zeer vroeg stadium van de ziekte van Parkinson kunt herkennen.”

Naast het probleem van AI als black box is er de vraag in hoeverre de rol van de mens zal veranderen in een wereld vol kunstmatige intelligentie die misschien wel slimmer is dan wij. “Dat wij de baas zijn op aarde, komt simpel gesteld doordat wij de slimste wezens zijn. Dat zal veranderen als machines slimmer worden dan wij en op sommige vlakken is dat al het geval. Hierdoor verliezen we in zeker opzicht de controle, al is het alleen maar omdat we beslissingen door computers laten nemen die we niet meer kunnen verantwoorden, omdat we niet precies weten waarom de AI een bepaald advies heeft gegeven.”

In Europa willen we de ethiek vanaf het begin inbouwen in kunstmatige intelligentie en robotica

Welke nieuwe regels zouden er dan moeten komen in een wereld met een dominante rol voor kunstmatige intelligentie? Volgens Müller is het nog te vroeg om daar al te veel over te zeggen. “We begrijpen eigenlijk nog te weinig van de impact van AI. We zullen de ontwikkelingen op de voet moeten volgen, en ons voortdurend moeten afvragen of de huidige wetten en regels nog wel voldoen. Met name op het vlak van aansprakelijkheid. Zijn de ‘passagiers’ verantwoordelijk voor ongelukken met een zelfrijdende auto, of de fabrikant? Ik denk het laatste, maar de Italiaanse wet schrijft bijvoorbeeld expliciet voor dat er altijd een bestuurder aanwezig moet zijn in een auto. Dat is een goed voorbeeld van een wet die moet worden aangepast voor autonome voertuigen.”

Aan de andere kant is de AVG al een forse stap in de juiste richting op het gebied van privacy in tijden van kunstmatige intelligentie, vindt de filosoof, die zelf zitting heeft in het wetenschappelijke adviescomité van AI4EU, een Europees platform. Het verschil met bijvoorbeeld de Amerikaanse of Chinese aanpak van kunstmatige intelligentie is duidelijk. “AI4EU probeert de Europese AI te positioneren als human centered AI, of responsible AI. In Europa willen we de ethiek daarom vanaf het begin inbouwen in kunstmatige intelligentie en robotica.”

Discussie